网络安全需要可解释的AI

现代的网络安全水平已经达到了很高的层次,特别是在人工智能的加持下。网络攻击及其方法的复杂性也显着增加,甚至超出了人类的理解能力。这也导致了网络安全从业者使用AI来对抗AI驱动的网络攻击成为一个相当大的挑战。

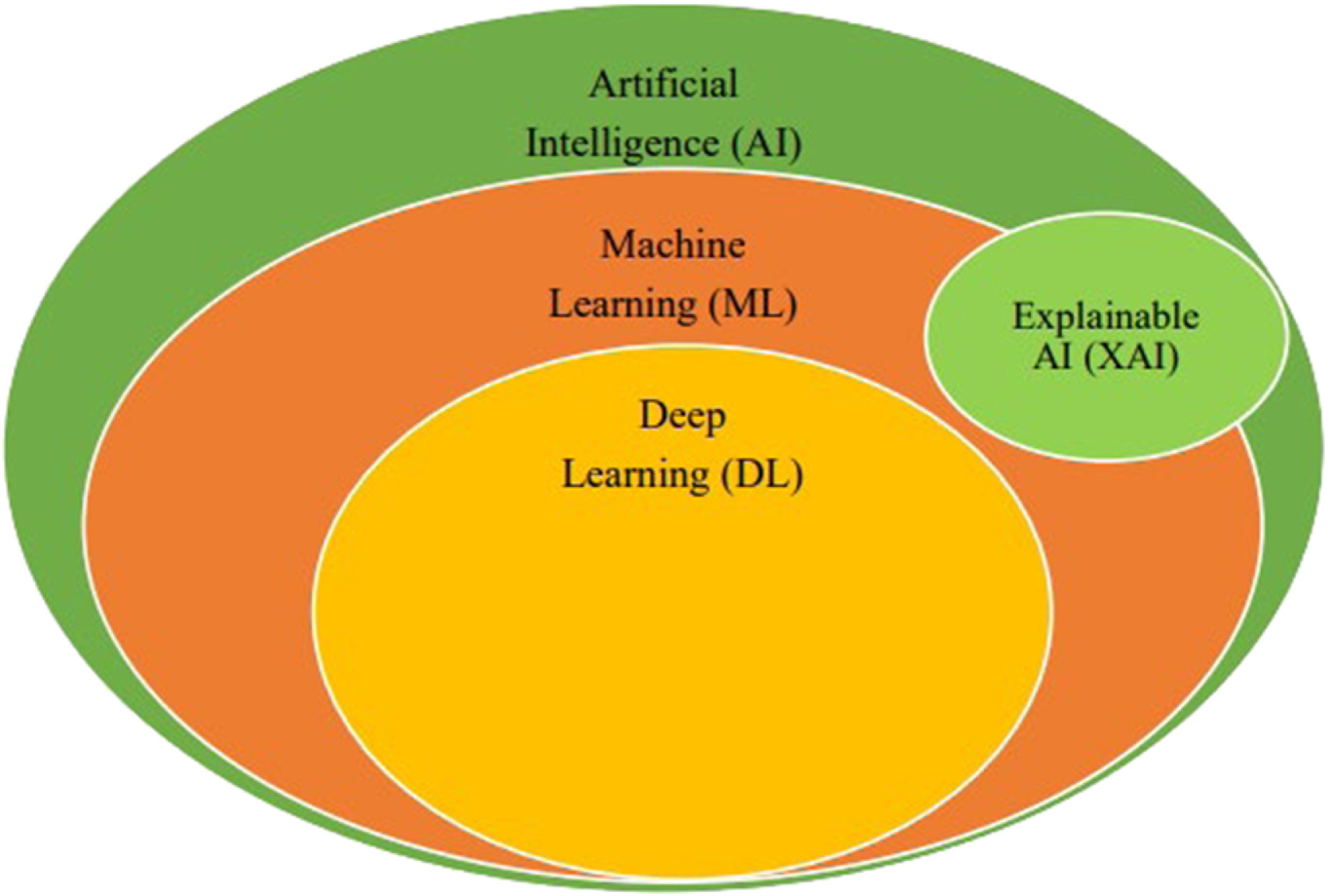

机器学习模型的广泛使用往往忽视了确保决策准确性、可靠性和公平性的重要性。随着人工智能生成的攻击不断增加,安全从业者必须优先了解人工智能模型的内部运作方式。这种更深入的理解在采用或部署之前至关重要。这是通过可解释的人工智能(XAI)实现的。

2017 年初,美国国防高级研究计划局 (DARPA) 引入了可解释的人工智能,以提高人工智能系统的透明度。XAI 涵盖的技术、设计原则和流程使开发人员和组织能够增加人工智能算法的透明度,XAI 可以描述人工智能模型、其预期影响和潜在偏差,从而使人工智能流程和决策更容易为人类所理解。

美国国家标准与技术研究所(NIST)引入了可解释人工智能的四个原则。这四个原则指导解释如何满足用户需求。这是当前一个积极研究的领域。

解释原则要求人工智能系统为其结果或过程提供证据或推理,这些信息无需清晰和明确的说明,并通过其他原则(例如意义和准确性)进行评估。鉴于不同的系统和场景,执行中的解释也有很大差异。因此,采用了广泛的定义来适应各种应用。

当使用者理解系统的解释时,就说明具有意义。诸如说明系统为何以某种方式运行等因素有助于这种理解。开发者必须考虑受众的知识和心理差异。意义性原则涉及了解受众的需求、专业水平以及与问题的相关性

解释准确性确保真实反映系统的流程或输出原因,这与决策准确性不同。决策准确性衡量的是正确性,而解释准确性则侧重于真实性。这一原则允许灵活地确定解释的准确性,以满足不同受众的需求和背景。

知识限制确保系统在其设计条件内运行,并对其输出具有足够的信心。这一原则确定了系统超出范围运行或答案不可靠的情况。通过声明知识限制,系统可以防止不适当的判断,通过防止产生误导或危险的输出来增强信任。

XAI 模型可解释性是指 AI 模型所做决策的明确性和可解释性。它衡量人类理解决策背后推理的能力。ML 模型的可解释性越高,其预测就越容易理解。在《可解释机器学习》一书中,提出了以下 XAI 分类法:

可解释性可以是与生俱来的,也可以是后期训练的,这表明是否模型自身具备可解释性、或者需要后期训练来强化可解释性。像决策树这样的简单模型是与生俱来的,而后期训练方法是外在的。如果需求不复杂,使用更简单的模型可能就足够了,而复杂的模型对人类的理解提出了挑战,通常需要后期训练。

特定于模型的方法是针对特定模型的,而模型无关的方法可以应用于任何机器学习模型。模型无关的方法无法访问内部模型数据,如权重和结构细节,因此它们在不同模型中具有多功能性。

局部方法解释单个预测,而全局方法解释整个模型的行为

可解释性对于理解 AI 系统中的因果关系至关重要,而解释性则更进一步,通过以人类可读的格式阐明模型如何以及为何做出预测。在网络安全中,AI 经常作为一个黑盒运行,实现可解释性和解释性变得至关重要。

• 威胁检测:XAI 使网络安全分析师能够了解为什么特定活动或异常被标记为潜在威胁,从而揭示检测系统的决策过程。

• 事件响应:XAI 协助网络安全调查人员发现安全事件的根本原因,并更有效地识别潜在的危害指标。

• 漏洞和风险评估:XAI 技术提供漏洞和风险评估的透明度,帮助组织了解为什么确定某些漏洞的优先级,并实现更清晰的安全措施和资源分配。

• 合规性和监管:XAI 通过为人工智能驱动的数据保护和隐私决策提供清晰的解释,帮助组织满足 GDPR 或 HIPAA 法规。GDPR 和 HIPAA 要求透明度,将黑盒运行的人工智能纳入法律监管,特别是对于受这些法规约束的组织。

• 安全自动化:XAI 通过解释人工智能系统所采取的操作,增强了自动化安全流程的透明度,例如防火墙规则生成或访问控制决策。

• 模型验证和确认:XAI 支持验证网络安全应用中使用的人工智能模型的准确性和公平性,确保它们按预期运行并且不会表现出偏见或意外行为。

对抗XAI的方法是用于分析和利用可解释人工智能 (XAI) 系统中的漏洞的技术。

当怀有恶意的个人在事后使用技术来隐藏其模型中的漏洞并声称他们的黑盒模型是公平的时,使用的就是利用解释机制进行攻击的方法。最近的研究还表明,人工智能系统提供的解释可能会受到输入数据的微小变化的影响,即使这些变化不会影响最终的分类结果。

此外,攻击者利用暴露的解释来危害系统安全,导致隐私泄露和逃避攻击。隐私降级攻击涉及从模型中提取敏感信息或推断成员资格或属性。逃避攻击包括生成对抗性示例、数据/模型中毒和后门注入技术。

人工智能的广泛采用凸显了网络安全中对可解释人工智能(XAI)的迫切需求。XAI 增强了人工智能驱动决策的透明度和理解,这对于确保人工智能系统的安全性和信任至关重要。然而,即使是 XAI 也不能免受威胁。操纵解释和逃避攻击对系统安全和隐私构成重大风险。展望未来,优先考虑研发工作以主动应对这些威胁至关重要。

* 本文为金东东编译,原文地址:https://www.tripwire.com/state-of-security/ai-transparency-why-explainable-ai-essential-modern-cybersecurity

图片均来源于网络,无法联系到版权持有者。如有侵权,请与后台联系,做删除处理。