DeepSeek数据安全受质疑?透视AI,安全无国界!

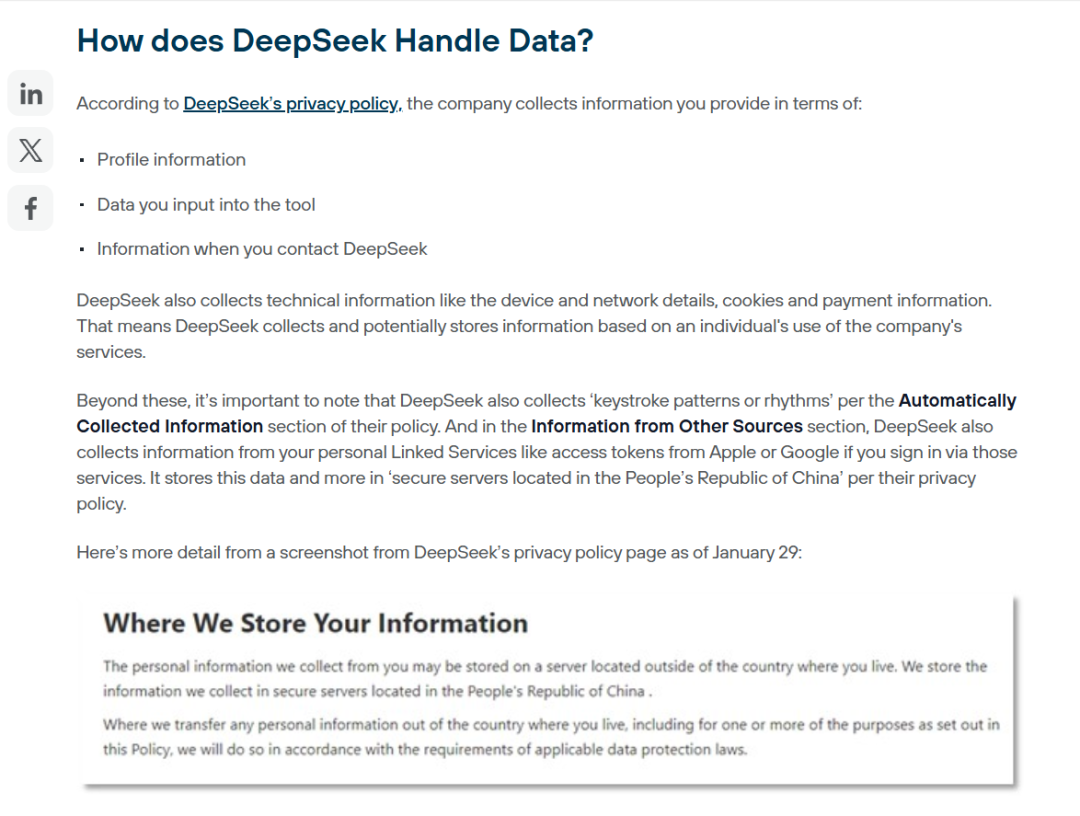

在数字化浪潮中,AI大模型的应用已经渗透到各个领域。无论是DeepSeek还是OpenAI,这些工具在为人类带来效率和便利的同时,也引发了一场关于数据安全与隐私保护的大讨论。 最近,美国 Forcepoint 公司一篇关于“使用DeepSeek大模型存在数据安全隐患”(Is your data safe in DeepSeek?)文章引发了广泛讨论,文中列举了DeepSeek的数据收集方式、存储位置以及潜在的被执法机构访问的风险。 DeepSeek的数据处理方式真的更危险吗? 先来看看文章的核心观点:DeepSeek可能因数据存储在中国而面临政府访问的风险。然而,这种逻辑是否成立呢? 事实上,任何一家AI公司都需要收集用户的数据来优化服务 ,无论是DeepSeek、OpenAI还是其他平台,无一例外。区别在于,DeepSeek明确说明了数据存储的位置和方式。 而国外一些AI公司往往以“商业机密”为由,对数据处理细节讳莫如深。如ChatGPT中对于隐私政策保护的条款中提到: 换句话说,我们不能仅仅因为一家公司的服务器位于某个国家,就断定它的数据安全风险更高。与其纠结于地理位置,不如关注以下几点: 国外的大模型真的“更安全”吗? 文章中提到的所谓“DeepSeek数据安全隐患”,其实并不是某个国家人工智能大模型的问题。以ChatGPT为例,它的服务条款中明确规定,所有在用户通过 Web 方式与 OpenAI 交互的数据,除非是在用户提前设置手工关闭对应选项情况下,否则用户提交的内容都会被用于改进模型,甚至可能在某些情况下与第三方共享。 以上截图中文字摘自于: https://openai.com/policies/privacy-policy/ 更值得关注的是,国外的大模型公司往往享有更大的技术垄断地位 ,它们对用户数据的收集和使用规则更加模糊。例如:OpenAI曾因未经同意将互联网上采集内容用于训练而引发争议。 国外OpenAI企业在全球范围内采集数据时,可能不受某些国家隐私法规的限制。 因此,与其说DeepSeek存在“更多问题”,不如说国外的一些大模型在数据处理上更具“隐蔽性”和“不可控性”。这种对比之下,反而凸显了中国企业在数据安全方面的透明度。 数据安全无国界,关键在于如何防范 无论选择哪家公司的AI服务,都会存在数据安全问题。与其陷入“此消彼长”的争论,不如把目光投向更本质的问题——如何在使用大模型时保护自己的敏感数据? AI是工具,不是终点;数据安全才是企业真正的命门。具体来说,可以采取以下措施: 天空卫士的解决方案——做您的数据安全“守护者” 无论你选择哪个平台,都需要有一套完善的数据安全机制来保驾护航。作为一家专注于数据安全的企业,我们深知:AI的快速发展离不开数据,但数据的安全性才是企业发展的基石。 天空卫士的数据安全解决方案,通过支持数据分类分级的深度内容识别技术,能够对用户提交到大模型的数据内容进行实时分析和审查,无论是文字、文件还是其他形式的数据,都能有效识别并屏蔽敏感信息。这不仅可以帮助企业规避因数据泄露带来的法律风险,而且也为企业的核心机密上了“双保险”。 此解决方案在实际部署处理时,也非常的便捷,可以对终端、Web 上网或者SASE 云服务进行管控,无论是通过内部网络访问,或者是通过开放的互联网使用 AI 应用,天空卫士的解决方案都可以灵活支持企业的整体 IT架构部署。 回到最初的问题:使用美国的大模型就一定更安全吗?答案是否定的。任何模型都可能存在数据安全风险,必须对企业员工、应用与大模型之间的交互内容进行严格的数据安全管控,才可以有效的降低风险,推动企业数字化转型的快速发展。